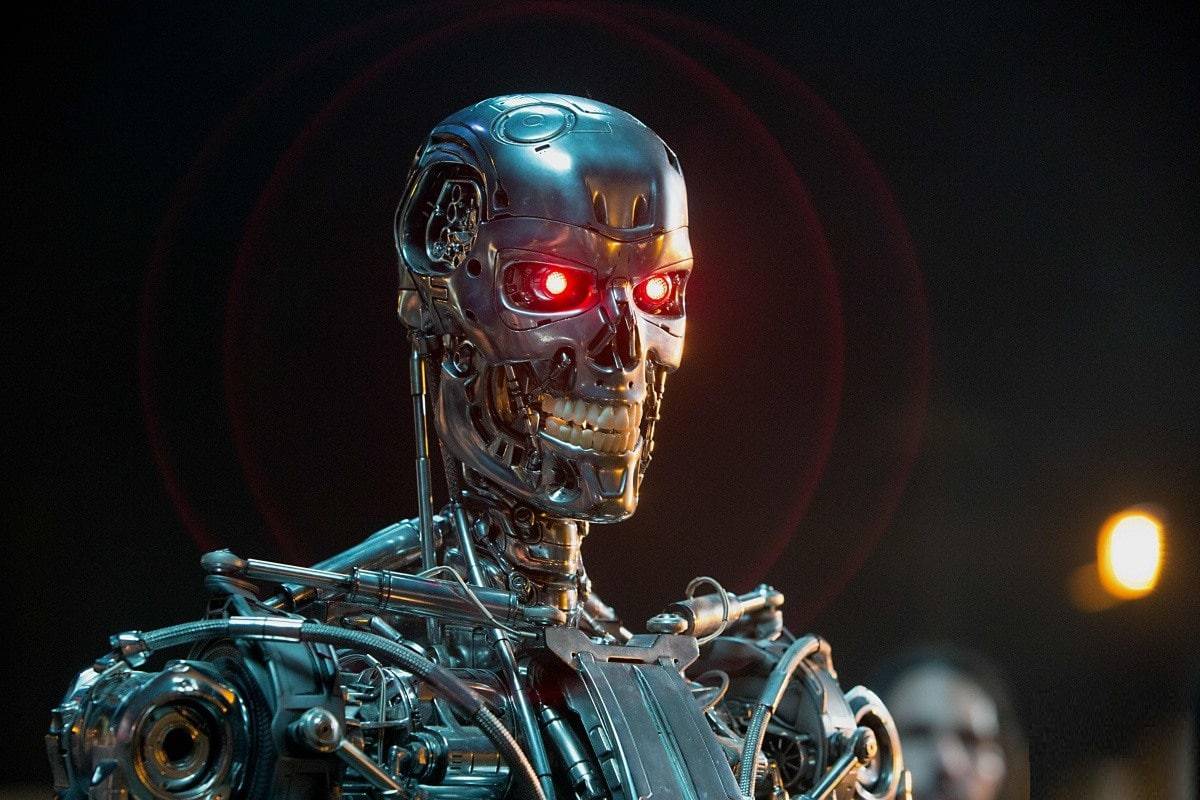

В последние несколько лет много говорят об угрозе искусственного интеллекта (ИИ). ИИ — это система, способная понять — или изучить — любую интеллектуальную задачу, которую может выполнить человек. Эксперты, казалось бы, из всех слоев общества говорили об этих типах систем ИИ, изображая их как роботов в стиле Терминатора, которые будут выходить из-под контроля и вызывать массовые войны и разрушения.

Илон Маск, генеральный директор SpaceX и Tesla, часто выступал против создания ИИ и изображал такие сверхинтеллектуальные системы в апокалиптических терминах. На SXSW в 2018 году он назвал цифровой сверхразум «самым большим экзистенциальным кризисом, с которым мы сталкиваемся», и сказал, что искусственный интеллект в конечном итоге будут более смертоносными, чем ядерная катастрофа. Покойный Стивен Хокинг разделял эти опасения, заявив в 2014 году Би-би-си, что «развитие полноценного искусственного интеллекта может означать конец человеческой расы».

С этим согласны и многие эксперты в области компьютерных наук. Показательный пример: Стюарт Рассел, профессор компьютерных наук и Смит-Заде, профессор инженерии Калифорнийского университета в Беркли, снялись в короткометражном фильме, в котором предупреждается об опасности роботов-убийц — оружия, использующего искусственный интеллект для идентификации и убийства без вмешательства человека. Цель фильма? Напугать людей и заставить принять меры по запрету сверхинтеллектуальных автономных систем вооружения на основе ИИ.

Алгоритмы ИИ уже наносят вред

Однако, мало кто возражает против того, что системы ИИ уже наносят вред людям. И да, системы ИИ уже наносят миру невероятный вред, но не по причинам, о которых думают большинство людей. Это не угроза всемогущего сверхразума, господствующего над человечеством или превращающего ресурсы всего мира в производство скрепок, о чем нам сейчас нужно беспокоиться больше всего. Такая реальность все еще остается далекой заботой. Именно общественные учреждения — социальные и коммерческие институты, которые уже используют ИИ, сегодня нам необходимо изучить, поскольку многие варианты использования уже наносят реальный и драматический вред людям.

Это серьезная проблема, когда речь идет об алгоритмах машинного обучения. Глубокое обучение — это семейство методов машинного обучения, которые используют нейронные сети для «обучения» компьютерного алгоритма распознаванию закономерностей. Это сопоставление с образцом — это то, как компьютеры могут распознавать и идентифицировать песни, услышав всего пару секунд музыки, обнаруживать речь и расшифровывать слова, которые говорит говорящий, и даже генерировать глубокие подделки. Все методы глубокого машинного обучения.

Всякий раз, когда мы слышим о том, что исследователи обучают алгоритмы распознаванию лиц, это значит, что исследователи изучают веб-сайты, такие как, Facebook, в поисках общедоступных фотографий для использования в какой-либо программе распознавания лиц и эти изображения являются данными, на которых обучается алгоритм машинного обучения. К счастью, как только изображения проходят через алгоритм, они, как правило, удаляются, так как они больше не нужны.

Но что, если на большинстве селфи, поступающих в алгоритм, изображены преимущественно светлокожие, «белые» лица? Что ж, тогда этот алгоритм станет очень хорошим в обнаружении таких лиц. Как в таком случаи он поведет себя, когда будет поставлена задача обнаружить и идентифицировать темнокожих людей?

Или заявки на кредит. Если бы ученые вводили каждое заявление на получение кредита в алгоритм машинного обучения, а также информацию о том, было ли это приложение одобрено или отклонено, то алгоритм машинного обучения был бы очень хорош в принятии тех видов кредитных приложений, которые были ранее приняты и одобрены и склонялся бы к отказы от тех, которые были отвергнуты ранее.

Но что, если данные, которые ученые ему предоставили, состояли в основном из 1) отклоненных заявок на получение кредита от заявителей из числа людей с определенной профессией и с безупречной кредитной историей и 2) принятых заявок от людей другой профессии, с менее чем безупречной кредитной историей? Если бы использовались именно эти данные, то алгоритм был бы непреднамеренно обучен оттачивать претендентов по их профессии, а не по кредитным баллам, и предполагал, что люди из определенной профессии должны быть отклонены, поскольку это по-видимому, лежит в основе процесса утверждения кредита. И алгоритм не ошибется, ведь на самом деле, он будет делать именно то, чему научили его создатели.

Как ИИ используется полицией

С 1990-х годов полицейские управления во всем мире полагались на статистику преступности, для размещения полицейских ресурсов в районах, где, согласно данным, происходит большая часть преступлений. Но если большая часть полицейских ресурсов направлена на конкретную область, на территорию, возможно, где проживают люди определенной социальной группы, то мы с большей вероятностью обнаружим преступление в этой области, поскольку на ней сосредоточены.

Если эти данные затем ввести в алгоритм, он обнаружит, что в этой области происходит больше преступлений, поэтому он направит в эту область больше ресурсов, что приведет к обнаружению большего количества преступлений в этой области, в то время, как в других областях алгоритм обнаружит меньше преступлений. Эта петля обратной связи не отражает, где на самом деле происходит преступление, она отражает, где алгоритм находит преступление, что является важной разницей.

Опять же, это не воображаемое, вымышленное будущее, о котором говорится. Эти предвзятые алгоритмы уже существуют и они используются в полицейских управлениях по всему миру. Очевидно, что в случае полицейской деятельности вред, причиняемый моделью машинного обучения, очевиден. Употребление наркотиков в разных расовых и демографических группах почти идентично, но предупредительная полиция в основном направляет ресурсы полиции на бедные районы, что приводит к непропорционально большому количеству арестов и разрушенным жизням.

Аналогично с распознаванием лиц, если правоохранительные органы используют систему распознавания лиц для выявления подозреваемых в совершении преступлений и этот алгоритм плохо обучен распознаванию темнокожих лиц, он будет давать большее количество ложных срабатываний. Если алгоритм распознавания лиц неправильно идентифицирует непропорционально большое количество подозреваемых, и эти ошибочные идентификации приводят к аресту или, что еще хуже, к осуждению, то этот алгоритм является не просто неверным, но и опасным.

Это еще большая проблема из-за того, как мы подходили к машинному обучению на протяжении многих лет: мы относились к нему так, как если бы оно не было предвзятым. И если заявка на получение кредита человеком была отклонена ИИ, это произошло не потому, что кредитный инспектор был предвзятым, а потому, что алгоритм отклонить заявку человека на основе данных, по которым ИИ был обучен.

Если в определенном районе слишком много полицейских, это не обязательно потому, что в этом районе более высокий уровень преступности — это означает, что ИИ заставил полицейских поверить, что в этом районе больше преступников. В каждом из этих случаев, если люди заменят человека алгоритмом машинного обучения и эта системная модель дискриминации и преследования бедных, условно говоря, которая была задокументирована на протяжении десятилетий, будет воспроизведена в ИИ — это будет означать, что ИИ будет преследовать людей определенной (бедной в данном случаи) социальной группы и защищать других или не замечать их преступления.

Нужно беспокоиться не о Скайнет

Однако, поскольку мы относимся к искусственному интеллекту так, как будто у него нет человеческих предубеждений, мы верим ему на слово, что приводит к тем же системным предубеждениям, которых мы «пытались» избежать. Проблема в том, чтобы использовать более качественные данные, или мы просто пытаемся заклеить зияющую социальную рану пластырем и надеемся, что проблема разрешится сама собой?

Конечно, учет предвзятости в обучающих данных машинного обучения позволит получить лучшие модели, но они не будут идеальными. Мы никогда не сможем полностью нейтрализовать или уравновесить модели, и есть все основания задаться вопросом, должно ли это быть целью вообще? Вместо того, чтобы просто пытаться создавать беспристрастные системы ИИ, что может оказаться невыполнимой задачей, возможно, нам нужно подвергнуть сомнению другие системы общества или начать их улучшение, например, воспитательные и образовательные институты, не говоря о том, чтобы выстраивать общество, где социальное расслоение будет намного меньше.

В конечном итоге, всё зависит от людей, и если некоторые люди идут на какие-то обходы закона, то часто это потому, что мир в котором они живут, для них не справедлив. Рашида Ричардсон, юрист и исследователь, изучающая алгоритмическую предвзятость в Юридической школе Рутгерса в Нью-Джерси (США), утверждает, что решение очевидно: наши усилия лучше направить на коренные проблемы, которые искусственный интеллект пытается решить. Другими словами, нам нужно сосредоточиться на устранении текущих реальных проблем в наших социальных системах. Затем мы можем сосредоточиться на создании инструментов ИИ.

Возможно, когда-нибудь в отдаленном будущем нам придется начать беспокоиться об ИИ в стиле Терминатора. Но на данный момент, разжигание страха не помогает и только отвлекает от разговоров, которые мы должны вести о реальном мире.

Джон Леффлер, публицист в области технологий